Case Studies

- 강의자료 다운로드: click me

학습 목표

-

개요

데이터사이언스와 산업 문제 해결

-

금융 도메인 사례(사기 탐지, 신용평가)

-

의료 도메인 사례(질병 예측, 의료 영상)

-

산업 도메인 사례(예지보전, 비전 기반 품질검사)

-

미니 캡스톤 (팀 프로젝트)

Introduction

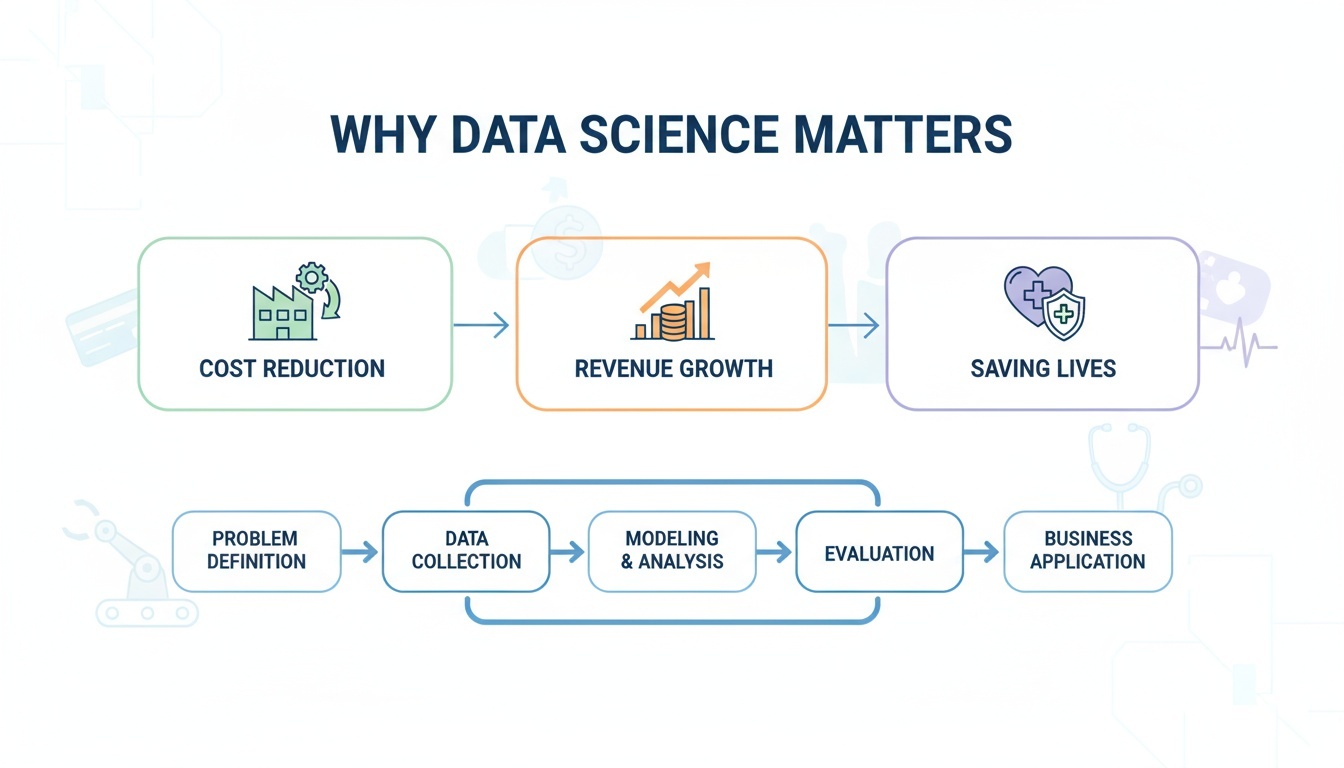

데이터사이언스는 더 이상 특정 기술 기업만의 전문 분야가 아니다. 오늘날에는 금융, 의료, 제조, 유통, 공공 서비스 등 다양한 산업에서 핵심 경쟁력을 만들어내는 필수 역량으로 자리 잡고 있다.

데이터 기반 분석과 예측 모델은 기업의 운영 비용을 절감하고, 새로운 매출 창출 기회를 발굴하며, 나아가 의료·안전 분야에서는 사람의 생명을 보호하는 데까지 기여하고 있다.

이번 섹션에서는 데이터사이언스가 현업의 실제 문제를 어떻게 해결하고, 어떤 가치를 창출하는지를 살펴본다. 특히 금융, 의료, 산업(제조) 영역에서 널리 활용되고 있는 대표적인 사례들을 중심으로 학습한다.

단순히 “어떤 모델이 사용되었다”는 기술적 관점에만 머무르지 않는다. 현장에서의 문제 정의부터 데이터 수집, 모델링, 평가, 그리고 비즈니스 적용까지의 전 과정 전체 흐름을 따라가며 이해할 수 있도록 구성하였다.

모든 사례는 아래의 공통 분석 패턴을 기반으로 설명된다.

문제 정의 → 데이터 수집 → 모델링·분석 → 평가 → 비즈니스 적용

이 프레임워크는 실제 데이터사이언스 프로젝트에서 가장 일반적으로 활용되는 절차이며, 이를 통해 이론으로 배운 개념들이 현실 세계의 문제 해결 과정에서 어떻게 구현되는지를 자연스럽게 체감하게 될 것이다.

이번 학습의 목표는, 데이터사이언티스트의 관점으로 문제를 바라보고, 해결 전략을 세우는 사고방식을 경험해보는 데 있다.

Finance Case Studies

Credit Card Fraud Detection

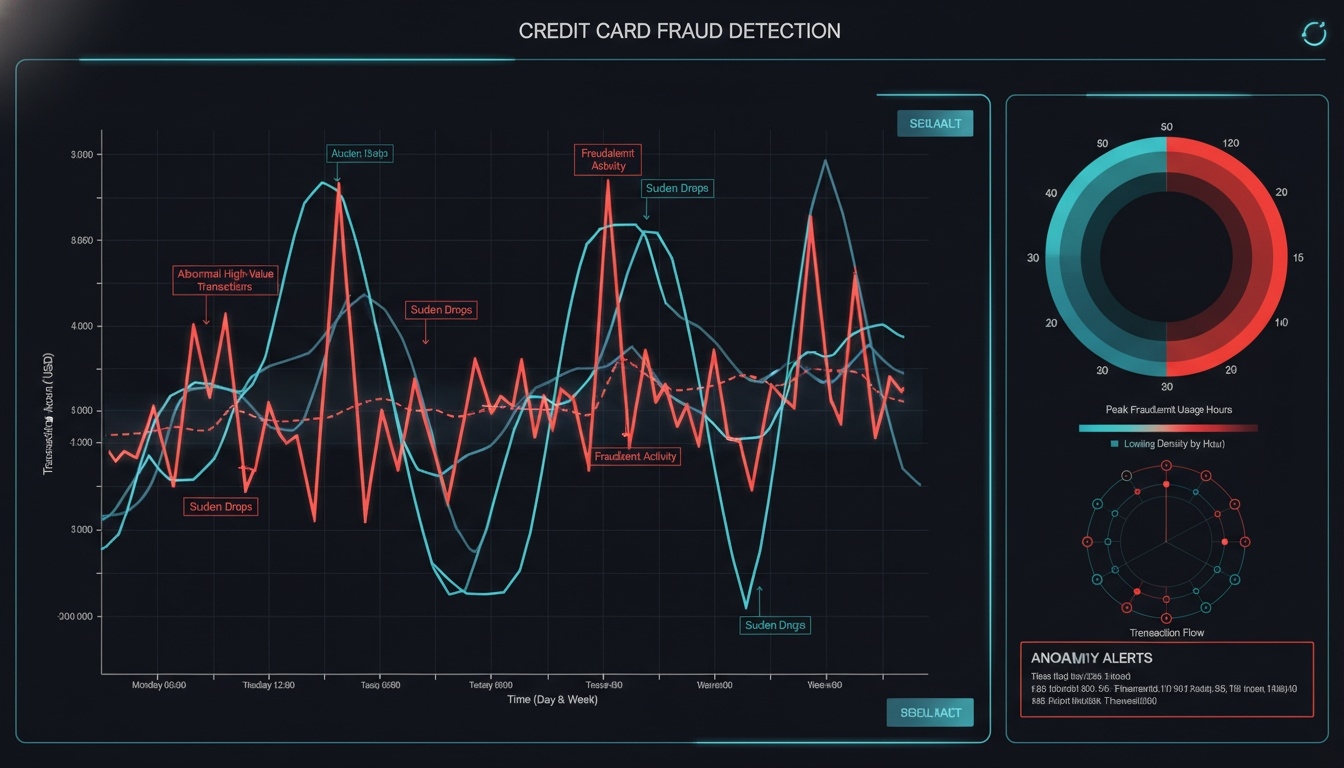

신용카드 사기 거래는 매년 증가하고 있으며, 금융기관은 실시간 탐지를 통해 고객 피해와 금융 손실을 최소화해야 한다. 데이터 사이언스는 거래 데이터를 분석하여 정상 패턴과 비정상 패턴을 구분함으로써 사기 거래를 조기에 발견하는 데 중요한 역할을 한다. 이 사례에서는 이상 거래 탐지 기법과 분류 모델을 적용해 실제 금융 서비스 환경에서 활용되는 분석 과정을 학습한다.

문제 정의

신용카드 거래 내역 중 사기 거래를 실시간으로 탐지하여 피해를 최소화하는 것이 목표이다. 사기 거래는 전체 거래 대비 매우 적은 비율로 발생하는 불균형 데이터 문제를 가지고 있으므로, 일반적인 정확도(Accuracy)만으로는 모델 성능을 적절히 평가하기 어렵다.

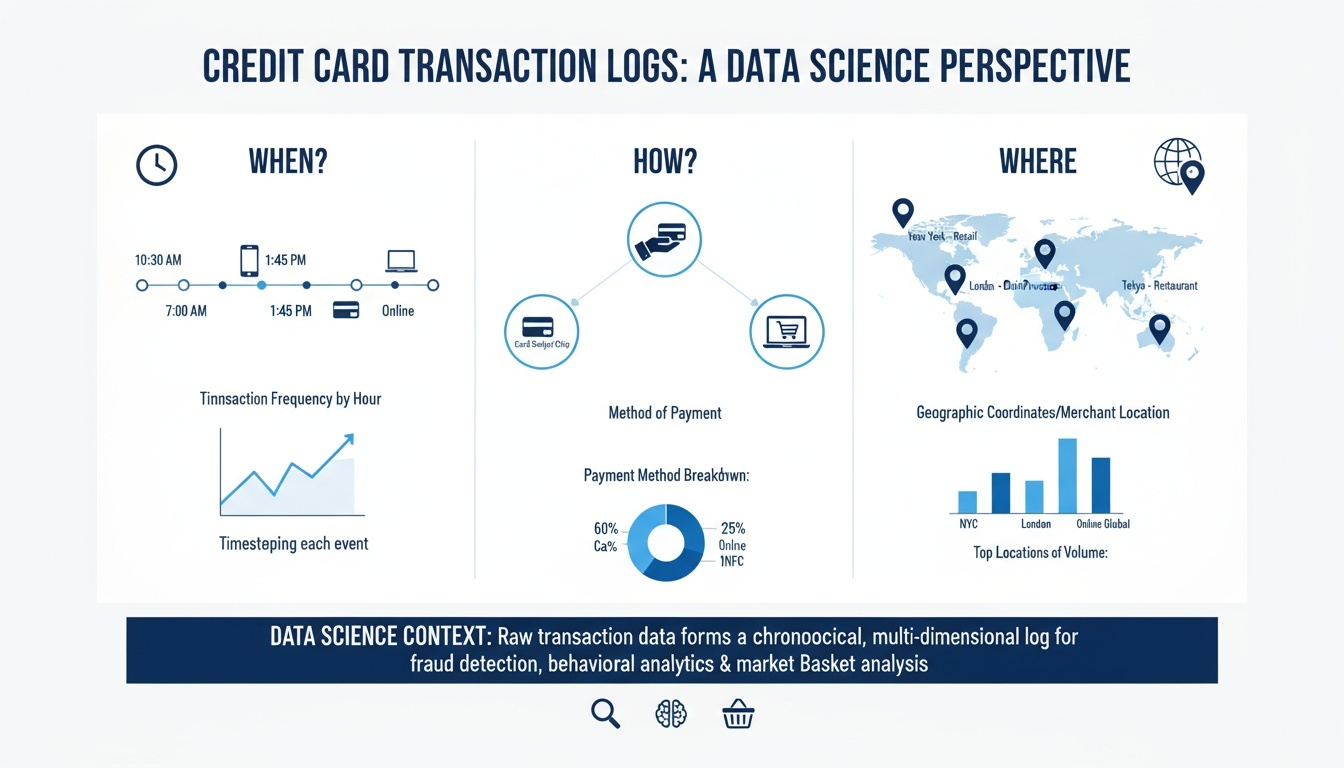

데이터 예시

- 거래 로그 (결제 시간, 결제 방식, 거래 지역)

- 결제 금액 및 사용 패턴

- 디바이스 정보 (사용 기기, IP, 위치 변화)

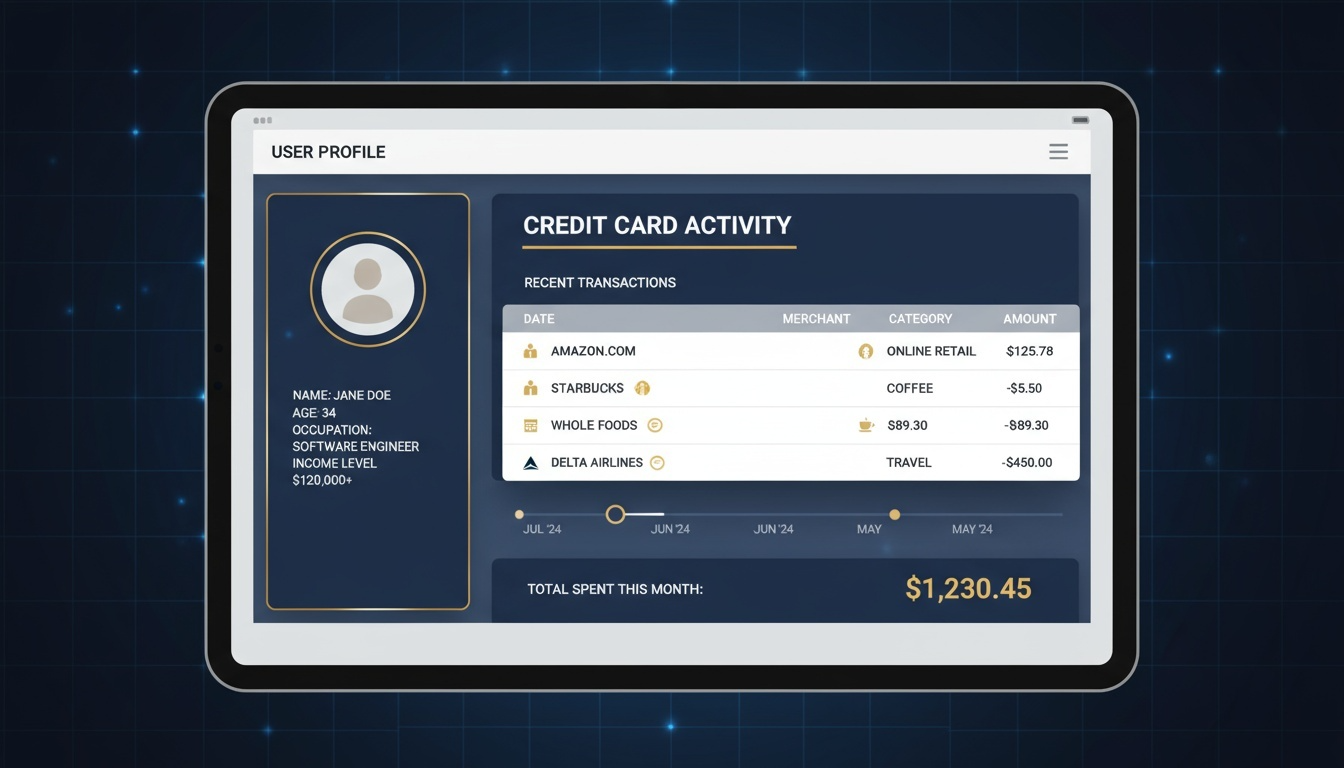

- 사용자 프로필 및 과거 거래 이력

다양한 데이터는 정상적인 사용 패턴과 사기 거래 패턴의 차이를 학습하는 데 활용된다.

분석 기법

-

이상치 탐지 기법 Isolation Forest, Local Outlier Factor(LOF)를 활용하여 정상 패턴에서 벗어난 거래를 탐지한다.

-

분류 모델 기반 탐지 Logistic Regression, Random Forest, XGBoost와 같은 지도학습 모델을 사용하여 거래를 정상 또는 사기로 분류한다.

-

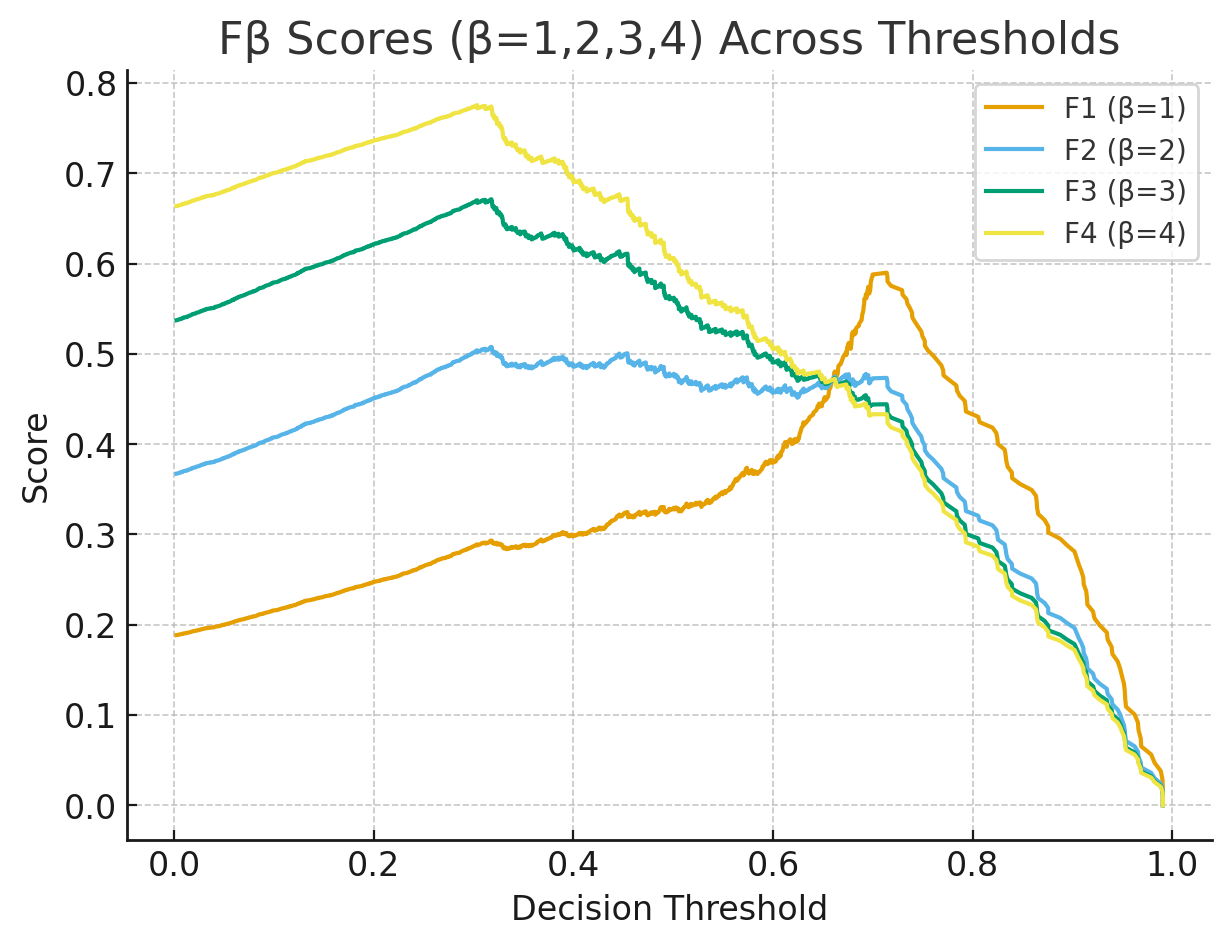

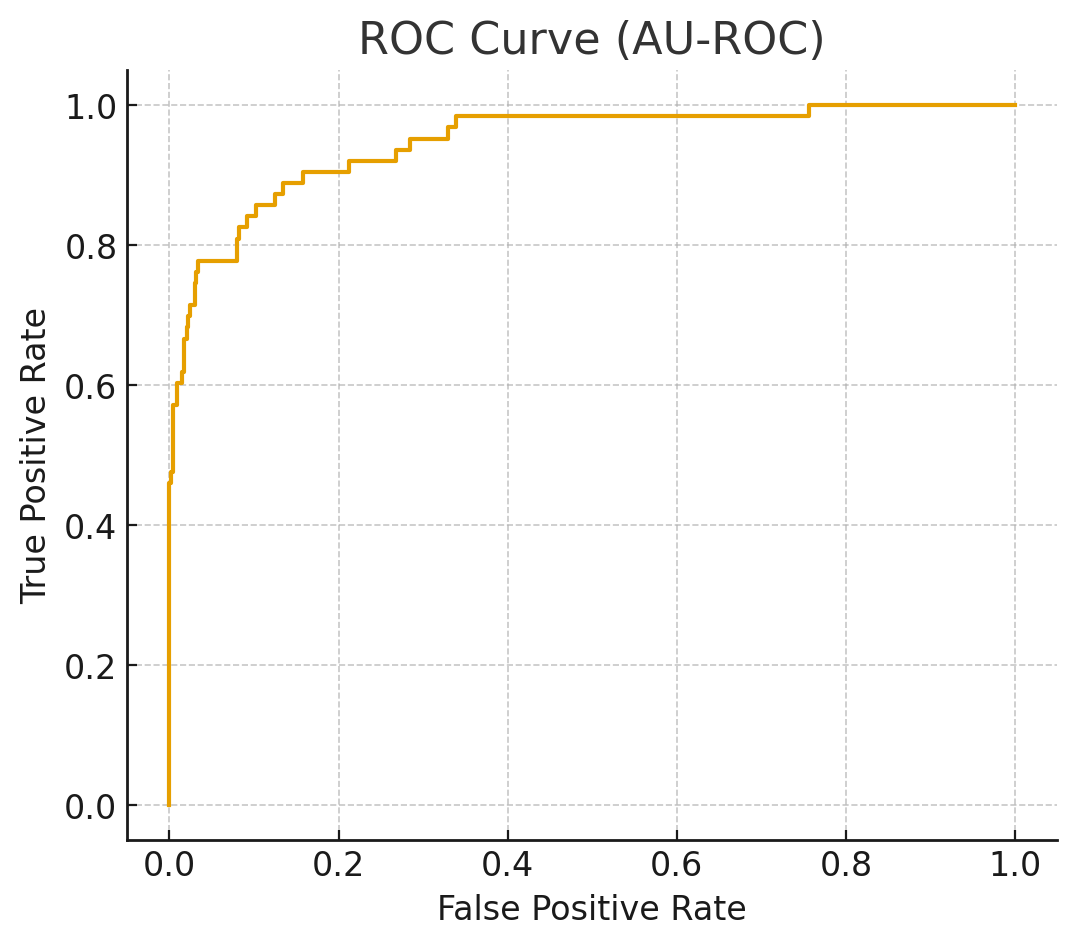

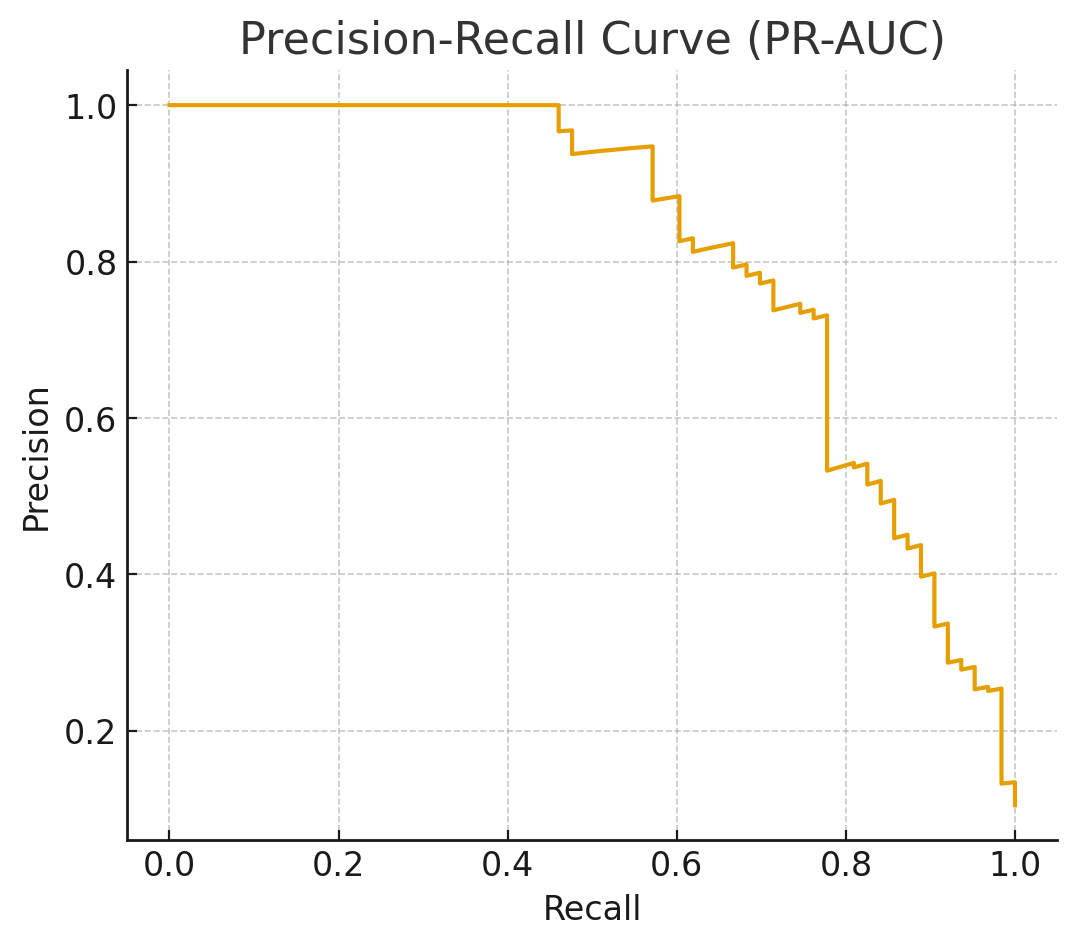

평가 지표 분석 Accuracy보다 Precision과 Recall의 균형이 중요하며, 특히 사기 거래를 놓치지 않는 Recall이 핵심이다. 다만, Recall만 높이고 Precision이 낮아지면 정상 거래 차단이 불필요하게 증가하기 때문에 두 지표 간의 적절한 균형 조정이 필요하다.

-

불균형 데이터에서는 Precision·Recall을 함께 보는 F1이 유용하지만, 사기 탐지처럼 Recall을 더 중시할 때는 \(\beta>1\)로 가중하는 \(F_{\beta}\)-score나 PR-AUC 등을 함께 검토한다.

- \(F_{\beta}\)-score: Precision과 Recall을 \(\beta\) 가중 조화평균으로 묶어, Recall 중요도를 반영한 단일 지표 \(\beta=1\)이면 F1과 같고, \(\beta>1\)이면 Recall을 더 강조하고 \(\beta<1\)이면 Precision을 더 강조한다.

- PR-AUC (Precision–Recall Curve): Precision-Recall 곡선 아래 면적; 클래스 불균형 상황에서 전 점수 구간의 분류 성능을 요약하며, AU-ROC(예측 순위 기반 TPR/FPR)보다 양성 클래스 품질에 민감하다.

기대 효과 및 분석 결과

적절한 모델 선택과 임계값 조정을 통해 사기 거래 탐지율을 높이면서 정상 거래 오탐률을 효과적으로 낮출 수 있는 전략을 수립할 수 있다.

Recall을 높여 사기 거래 탐지 능력을 향상시키되, Precision을 유지하여 정상 거래가 불필요하게 차단되는 상황을 최소화하는 것이 금융 서비스 품질 유지의 핵심이다.

Mini Project (1인 수행)

-

Kaggle의 Credit Card Fraud Detection 데이터셋 활용: 데이터셋 다운로드 (Kaggle)

-

(선택) 데이터 불균형 문제 해결 기법 적용

-

Logistic Regression, Random Forest, XGBoost 성능 비교

-

Random Forest, XGBoost 추가 학습이 필요함

-

Random Forest, XGBoost 적용은 선택 사항

-

-

F1 Score 및 AUC 기반 성능 평가

-

임계값 변경 시 Precision과 Recall 변화 시각화 분석

주의사항: 실제 금융권 모델 개발 시 고려해야 할 의사결정 요소들을 경험적으로 이해할 수 있다.

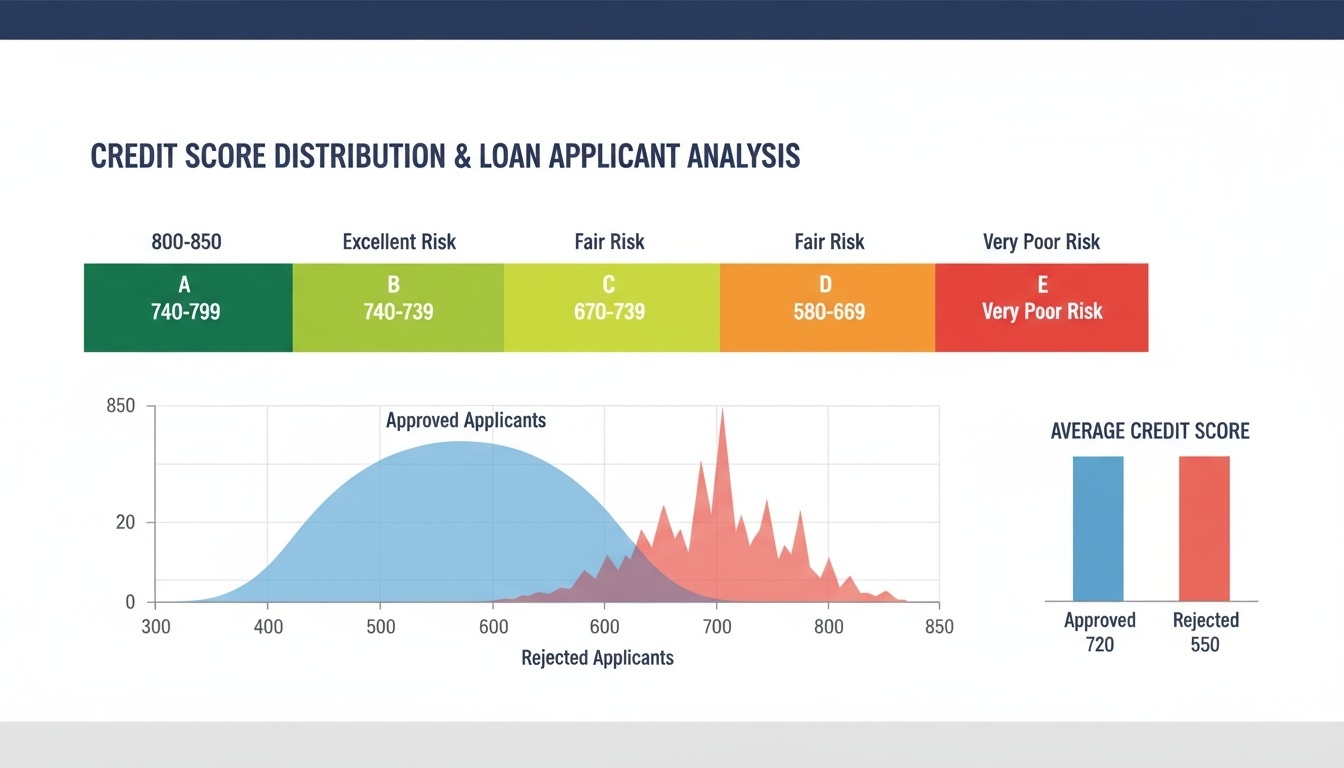

Credit Scoring

대출 심사 과정에서 금융기관은 고객의 신용도를 평가하여 대출 승인 여부를 결정한다. 데이터사이언스 기반의 신용평가 모델은 기존의 단순 점수 기반 방식보다 더 정확하고 일관성 있는 의사결정을 내릴 수 있도록 지원한다. 또한 모델이 내린 판단이 공정하며 설명 가능해야 하므로, 성능과 함께 해석력 역시 중요한 요소이다.

문제 정의

고객의 대출 신청에 대해 승인 또는 거절 여부를 정확하고 공정하게 예측하는 것이 목표이다. 특히, 특정 집단에게 불리하게 작동하는 편향된 모델이 만들어지지 않도록 데이터 선정, 모델 학습, 평가 기준에서 공정성이 고려되어야 한다.

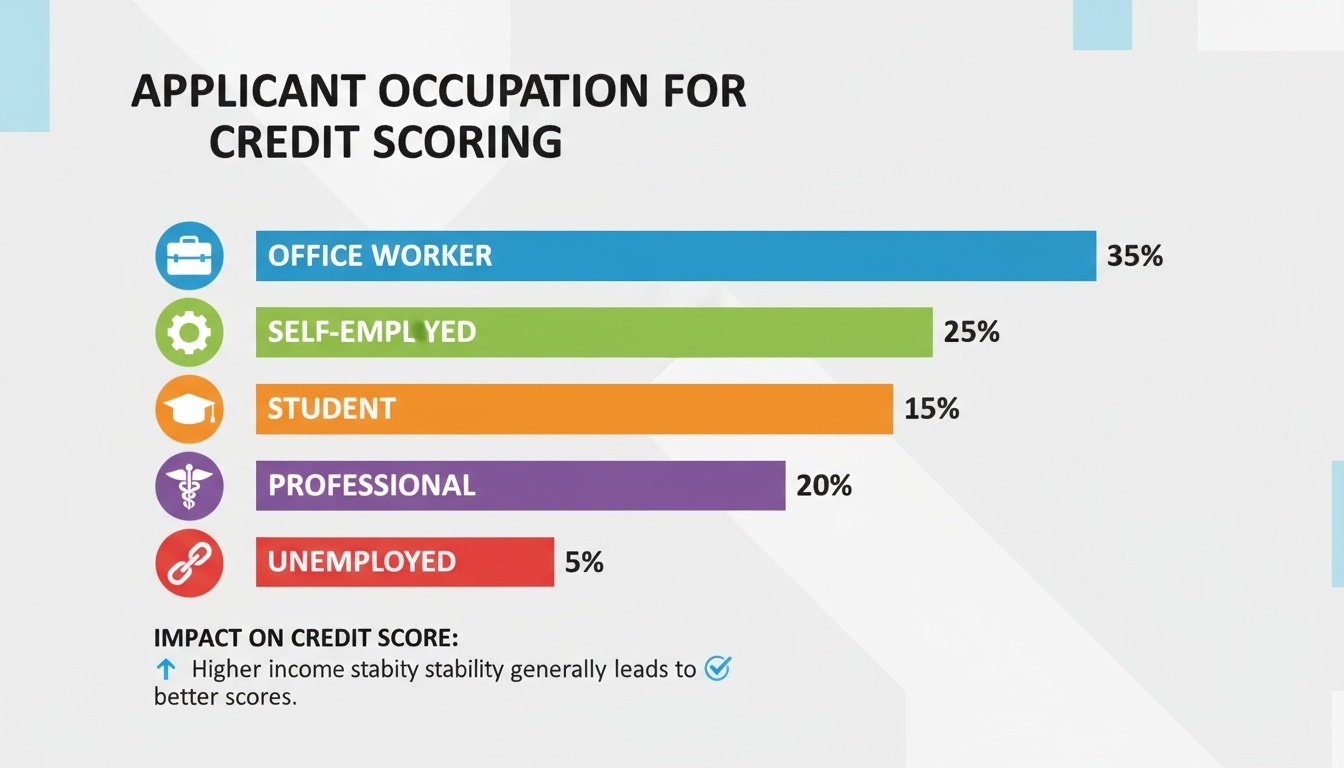

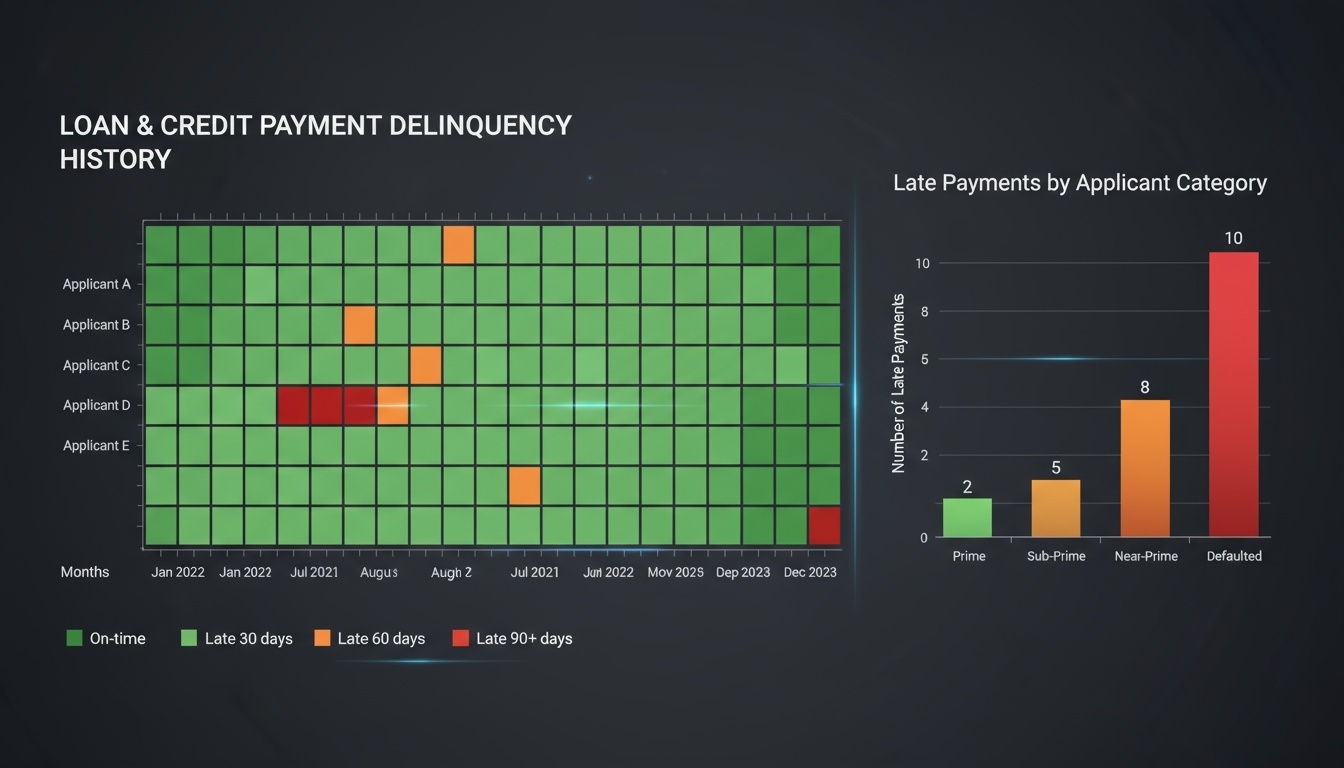

데이터 예시

- 소득 수준

- 직업 정보

- 연체 기록

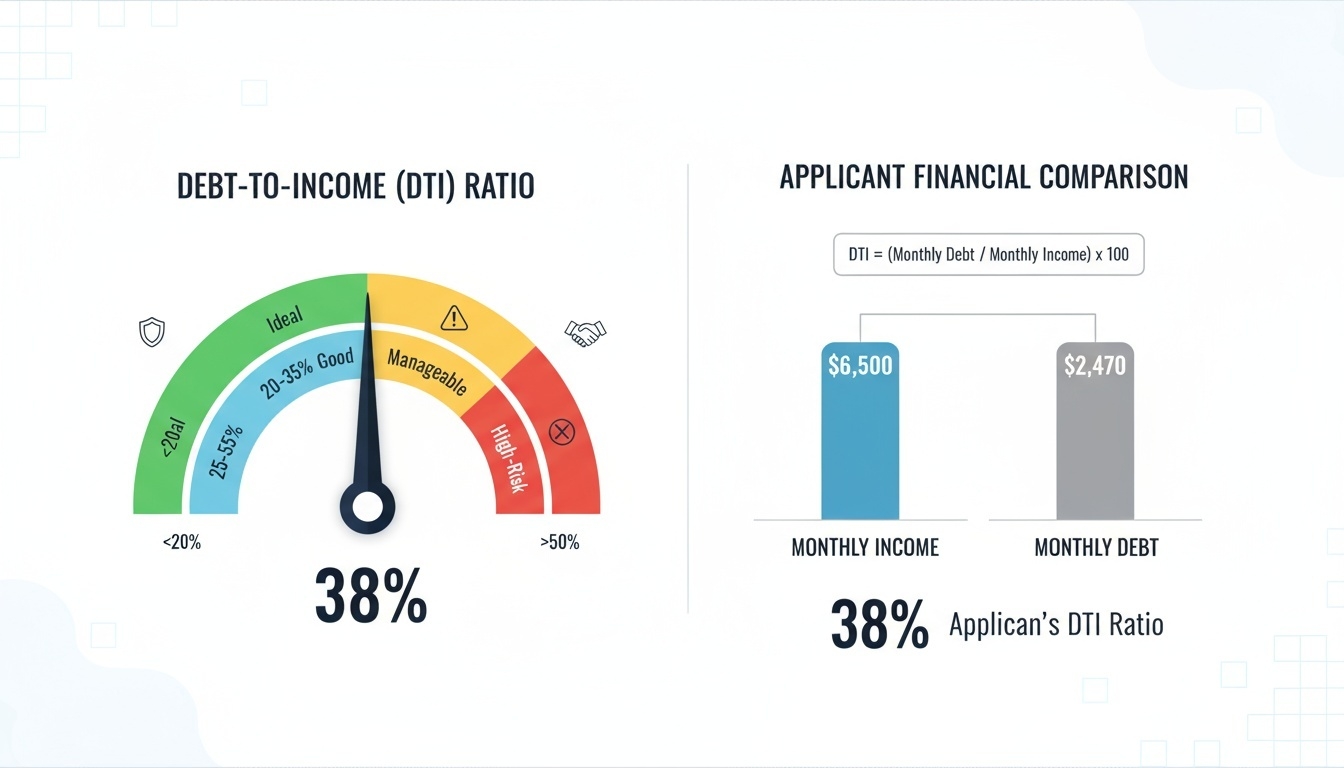

- 부채 비율(DTI, Debt-to-Income Ratio)

- 신용 등급

분석 기법

-

Logistic Regression 비교적 단순한 모델이지만 해석력이 뛰어나며, 어떤 변수들이 대출 승인 결정에 영향을 미치는지 명확히 확인할 수 있다.

-

LightGBM 대용량 데이터 학습에 강점이 있으며 높은 예측 성능을 보이는 부스팅 모델이다. 다만, 모델 구조가 복잡하여 해석이 어려울 수 있다.

-

모델 해석 및 공정성 평가 모델 예측 결과에 대한 설명 가능성(XAI, Explainable AI) 기법을 적용하여 모델의 판단 근거를 확인한다. 고객 속성에 따른 차별적 영향 여부를 분석하며, 금융 공정성(Fairness) 관점에서 모델을 평가한다.

- 설명 가능성(XAI)은 모델이 어떤 특성을 근거로 결론에 도달했는지 시각화·정량화하는 기법(예: SHAP)으로, 블랙박스 모델의 결정 과정을 투명하게 만들어 규제 준수와 이해관계자 신뢰를 높인다.

기대 효과 및 분석 인사이트

Logistic Regression과 LightGBM을 비교함으로써 성능과 해석력 간의 균형을 이해할 수 있다. 또한 XAI 기법을 통해 모델이 어떤 요인을 근거로 결정을 내렸는지 파악함으로써 금융 서비스에서 투명성과 공정성을 확보하는 것이 중요함을 확인할 수 있다.

Mini Project (팀 수행)

-

2명 이상이 팀으로 진행할 것

-

토론 결과는 보고서로 작성하여 제출할 것 (제출 파일:

.hwp,.docx) -

토론 주제

-

해석력이 높은 모델과 성능이 높은 모델 중 금융권에서는 어떤 모델을 선택해야 하는가?

-

특정 연령, 직업, 성별 집단에 대해 모델이 불리하게 작동한다면 어떻게 개선할 수 있는가?

-

XAI가 실제 금융 의사결정 과정에서 어떤 역할을 할 수 있는가?

-

Healthcare Case Studies

Disease Prediction

의료 분야에서 데이터사이언스는 질병 발생 가능성을 조기에 예측하여 예방적 치료와 맞춤형 관리가 이루어질 수 있도록 지원한다. 특히 당뇨병, 심장 질환과 같은 만성 질환은 조기 발견 여부가 향후 치료 효과와 생존율에 큰 영향을 미치기 때문에 예측 모델의 정확성과 의료진 신뢰 확보가 매우 중요하다.

문제 정의

환자의 건강 데이터를 기반으로 질병 발생 가능성을 사전에 예측하는 것이 목표이다. 의료 분야에서는 질병 여부를 놓치지 않는 것이 매우 중요하므로, 정확도(Accuracy)보다 민감도(Recall)가 더 중요한 평가 기준으로 고려된다.

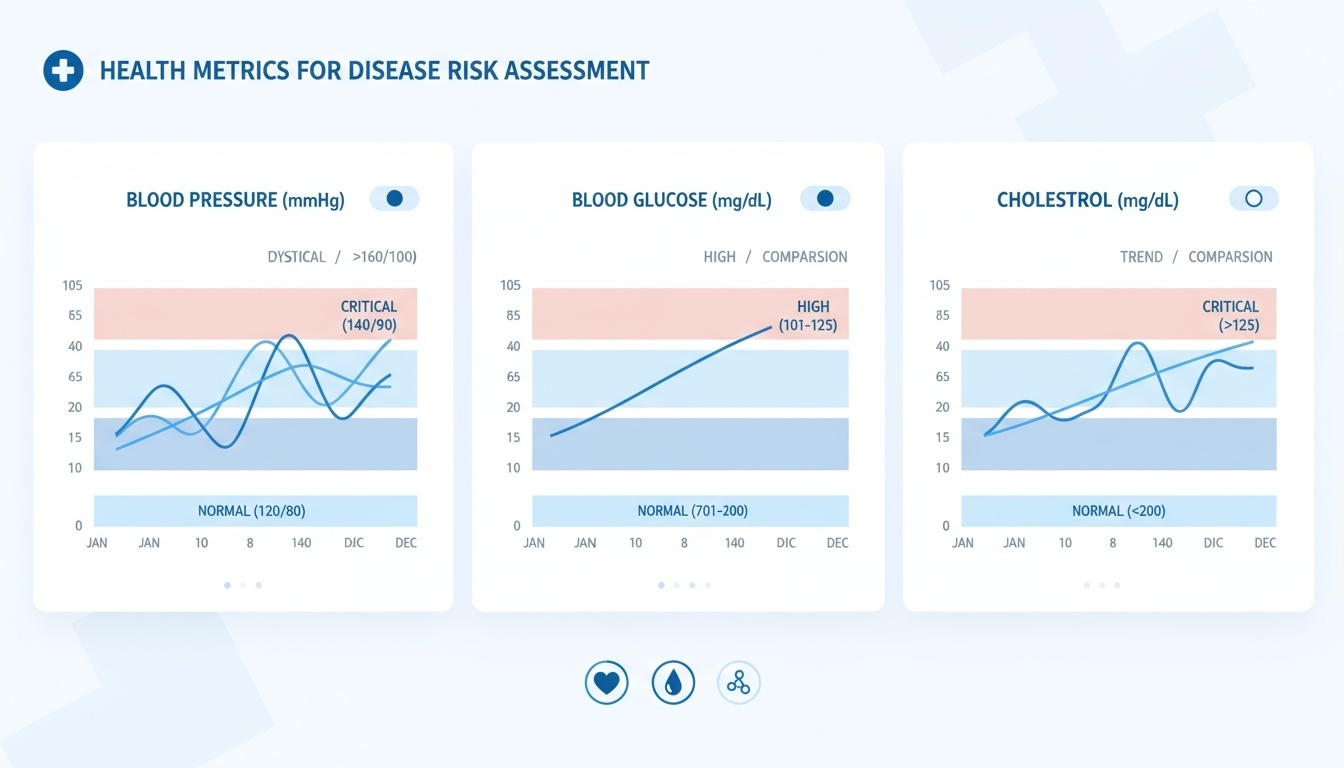

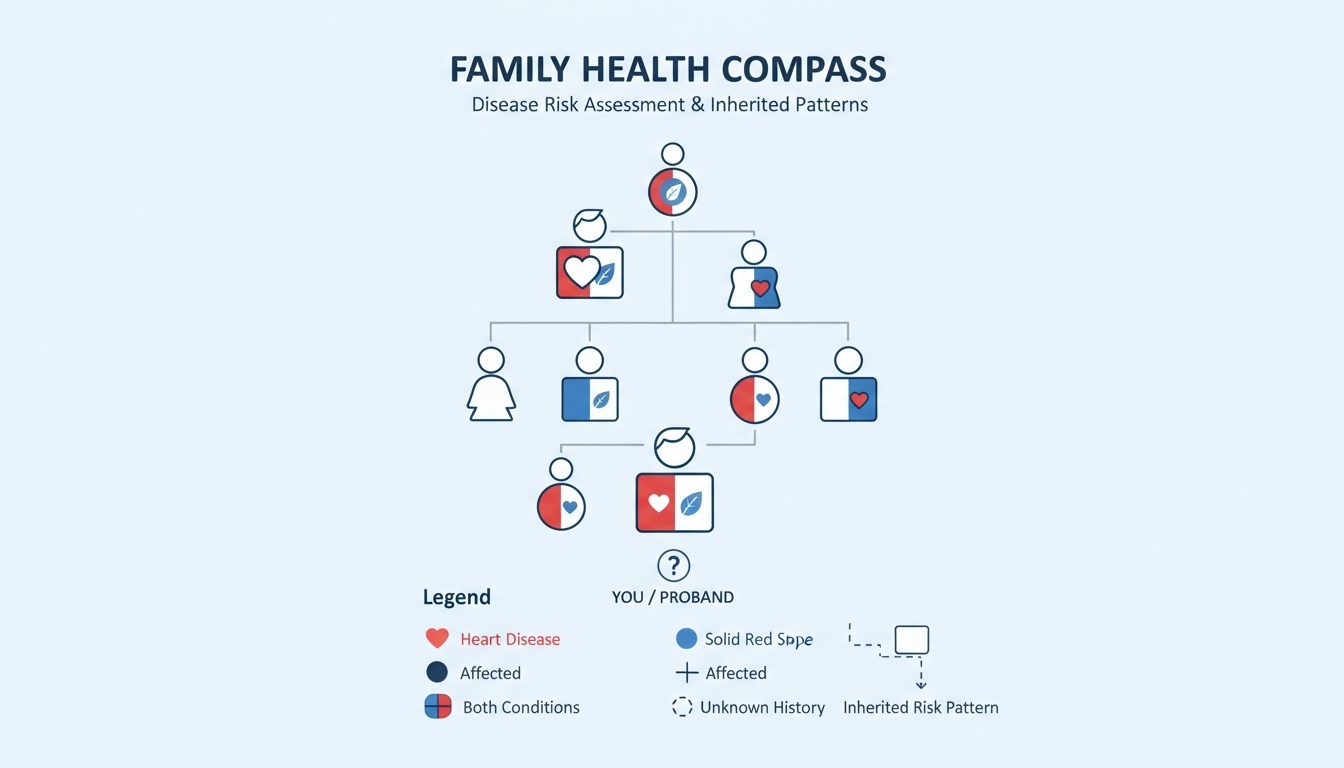

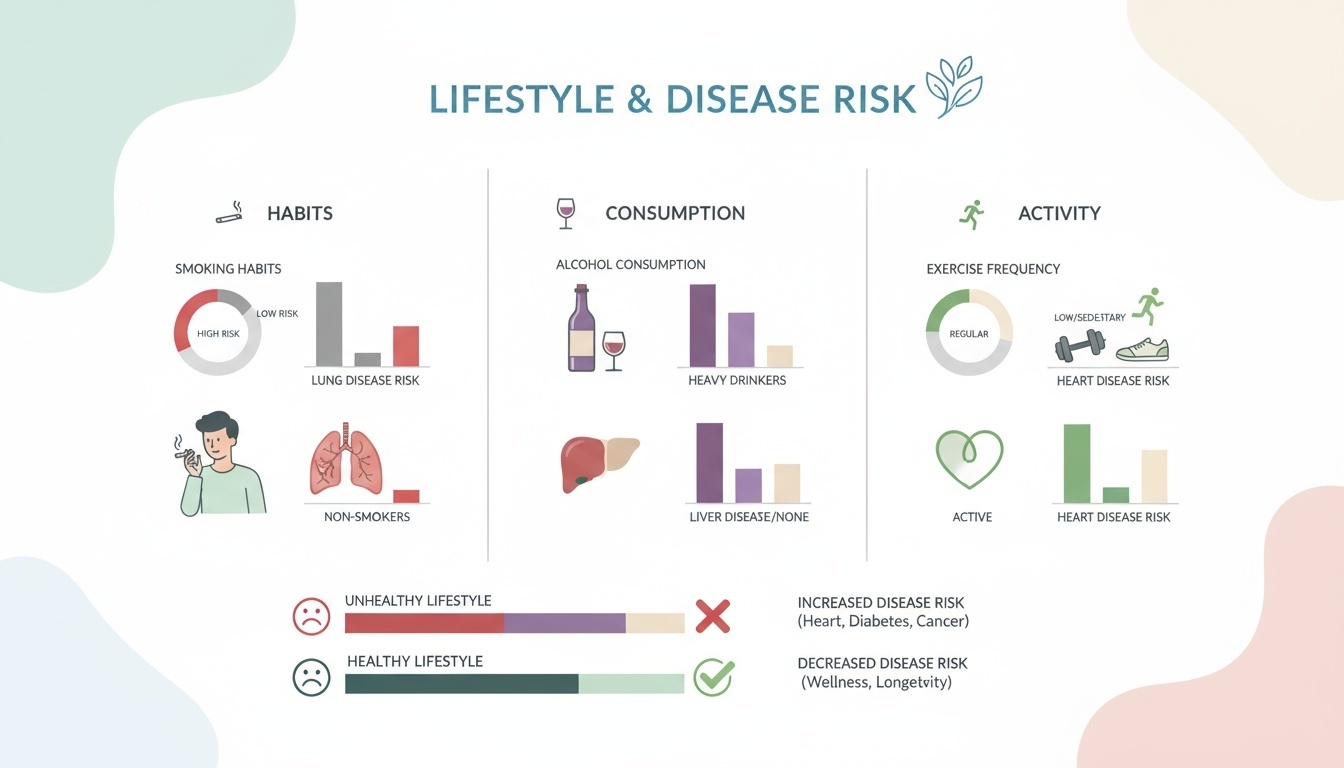

데이터 예시

- 건강검진 수치 (혈압, 혈당, 콜레스테롤 등)

- 가족력 정보

- 라이프스타일 정보 (흡연, 음주, 운동량 등)

분석 기법

-

분류 모델 비교: SVM과 Random Forest 모델의 성능을 비교해 본다.

-

SVM: 초평면으로 데이터 경계를 학습해 고차원에서 분류 성능을 높인다.

-

Random Forest: 여러 결정트리를 앙상블해 과적합을 완화하고 안정적인 예측을 제공한다.

-

Neural Network 모델을 적용하여 예측 성능을 비교한다.

-

-

모델 해석 기반 신뢰 확보 SHAP을 활용해 모델이 어떤 요인을 근거로 질병 위험을 판단했는지 설명함으로써 의료진과 환자 모두가 결과를 이해하고 신뢰할 수 있도록 한다.

기대 효과 및 분석 인사이트

질병 예측 모델은 의료진이 환자의 위험 요인을 사전에 파악하여 예방적 처치를 제공할 수 있도록 돕는다. 특히 의료 환경에서는 질병을 놓치는 경우(False Negative)의 비용이 매우 크기 때문에 정확도보다 민감도를 우선 고려하는 것이 중요하다.

예를 들어 심장 질환 위험 예측에서 Recall이 낮아 고위험 환자를 정상으로 판단하면 치료 시기를 놓쳐 심각한 결과로 이어질 수 있다. 따라서 의료 모델 평가에서는 Recall을 핵심 지표로 반영하는 것이 타당하다.

Mini Project (팀 수행)

-

2명 이상이 팀으로 진행할 것

-

토론 결과는 보고서로 작성하여 제출할 것 (제출 파일:

.hwp,.docx) -

토론 주제

-

질병 예측 모델이 높은 정확도를 보이지만 Recall이 낮다면 어떤 위험이 발생하는가?

-

의료 모델에서 Precision과 Recall의 균형을 맞추기 위한 전략에는 어떤 것이 있을까?

-

(선택) SHAP 기반 설명 가능성이 의료 AI 도입 과정에서 중요한 이유는 무엇인가?

-

Medical Imaging Diagnosis

의료 영상 진단 분야에서는 X-ray, CT, MRI 이미지 분석을 통해 질병을 자동으로 판별하는 기술이 빠르게 발전하고 있다. 딥러닝 기반 의료 영상 분석 모델은 진단 속도 향상과 정확도 제고에 기여하며, 의료진의 의사결정을 보조하는 핵심 기술로 활용되고 있다.

문제 정의

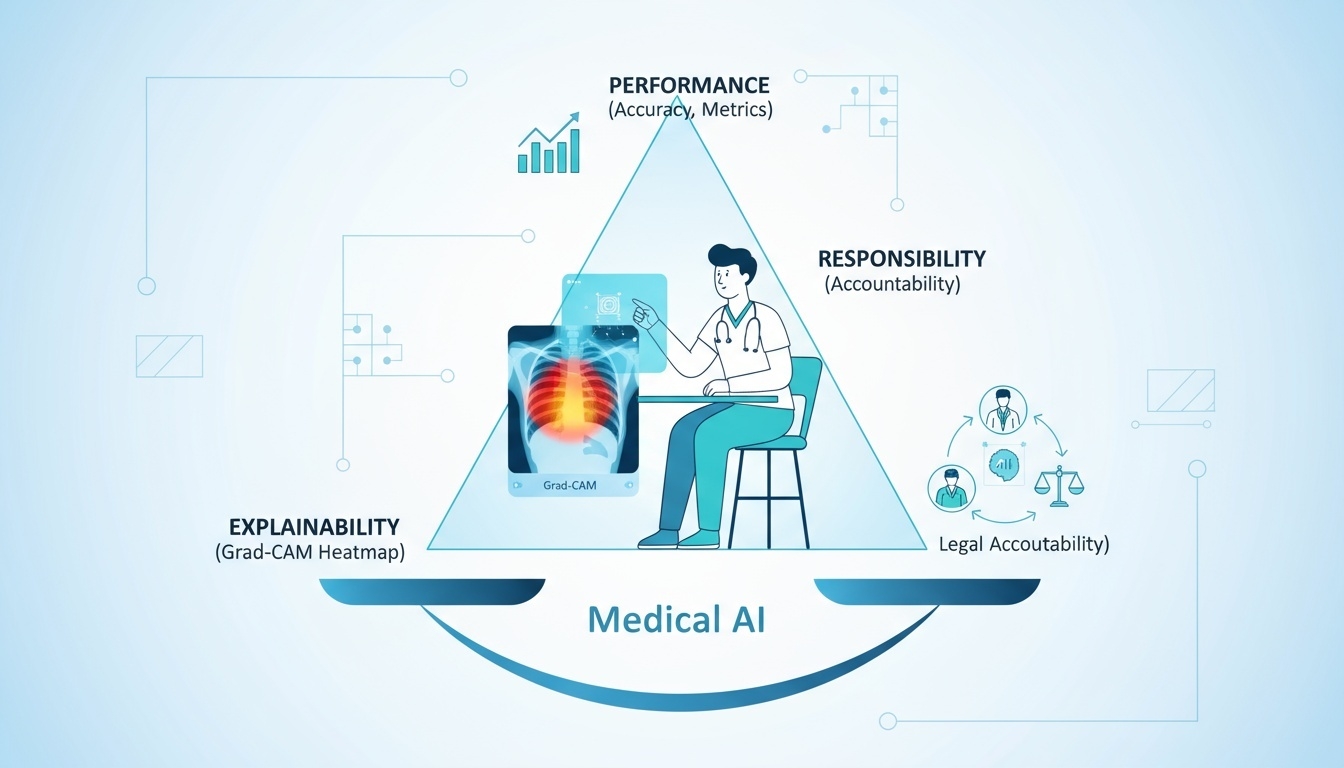

X-ray, CT, MRI 등의 의료 영상을 분석하여 질병 여부를 자동으로 검출하는 것이 목표이다. 의료 영상 진단 모델은 단순히 높은 정확도를 달성하는 것뿐 아니라 의료 현장에서 결과를 신뢰할 수 있도록 안전성, 설명 가능성, 법적 책임 문제가 함께 고려되어야 한다.

핵심 고려 요소

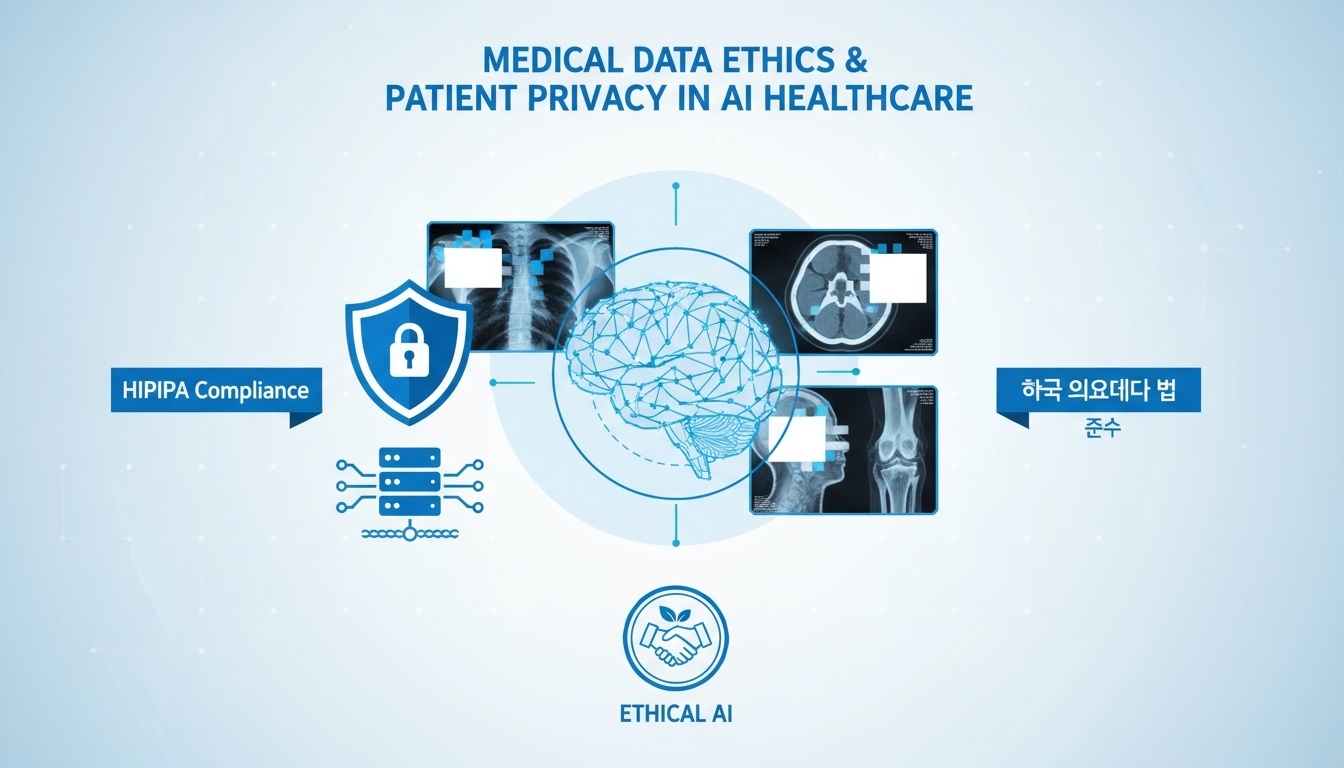

- 의료 데이터 윤리 및 개인정보 보호 의료 영상 데이터는 민감정보에 해당하므로 HIPAA, 한국 의료법 등 관련 규정을 준수해야 한다. 데이터 저장, 처리, 공유 과정에서 개인정보 비식별화와 보안 체계가 확보되어야 한다.

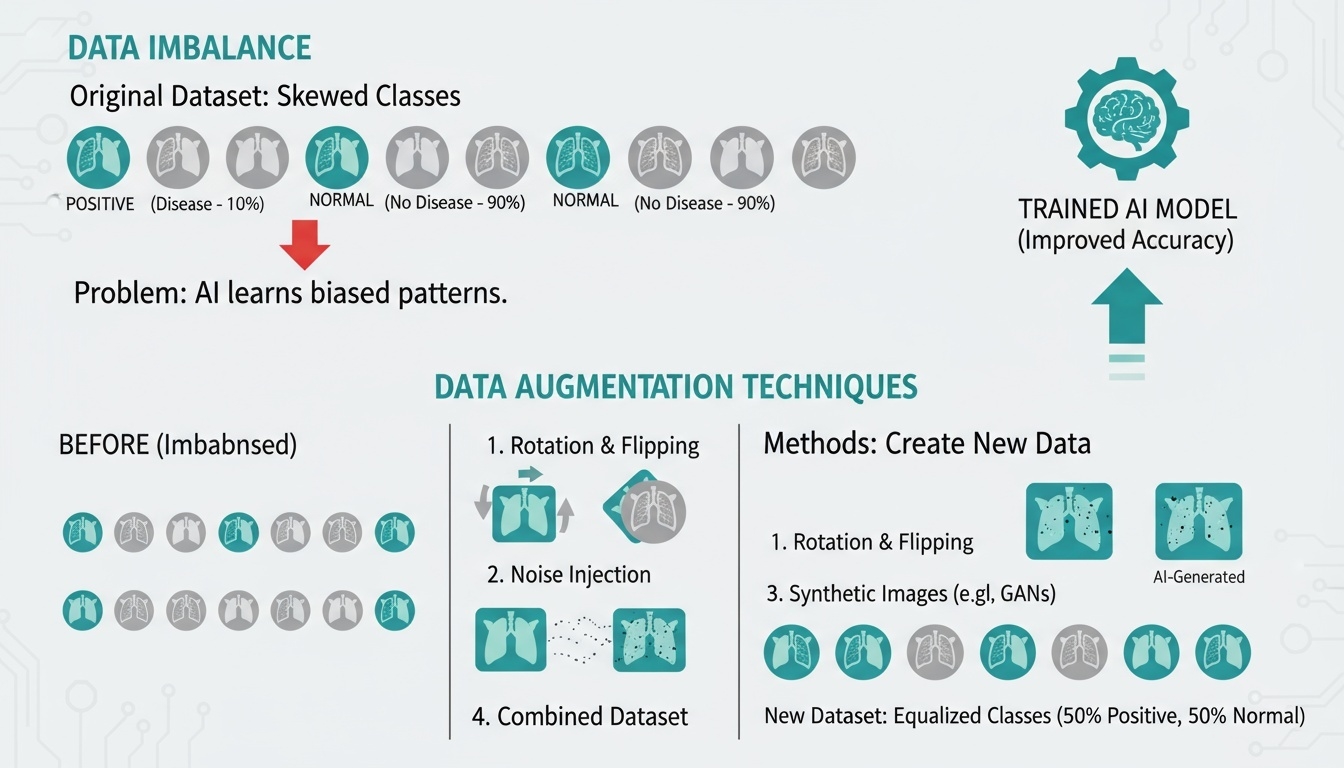

- 데이터 불균형 해결 및 증강 기법 질병 보유 환자 수가 적은 경우가 많아 데이터 불균형 문제가 발생한다. 이를 해결하기 위해 데이터 증강, SMOTE, 클래스 가중치 등 다양한 기법을 적용하여 모델의 일반화 성능을 높인다.

- 모델 성능, 해석력, 책임 소재의 균형 모델의 성능이 높더라도 진단 근거가 불분명하면 의료진이 결과를 신뢰하기 어렵다. 따라서 시각화 기법을 활용해 모델의 판단 근거를 제시하고, 오진 발생 시 책임 소재를 어떻게 규정할 것인지 논의가 필요하다.

기대 효과 및 분석 인사이트

의료 영상 진단 모델은 대량의 영상 데이터를 신속하게 분석하여 진단 효율성을 높이고 의료진의 업무 부담을 줄이는 데 기여할 수 있다. 특히 의료 영상 AI는 전문의 부족 지역에서 원격 진단 지원 기술로 활용될 수 있으며, 신속한 1차 판독 기능을 제공하여 치료 골든타임 확보에 도움이 된다.

다만 의료 AI가 독립적 진단 도구로 사용되기 위해서는 정확도뿐 아니라 설명 가능성과 법·윤리적 책임 영역이 명확히 정립되어야 한다.

Mini Project (팀 수행)

-

2명 이상이 팀으로 진행할 것

-

토론 결과는 보고서로 작성하여 제출할 것 (제출 파일:

.hwp,.docx) -

토론 주제

-

의료 영상 진단 모델이 높은 정확도를 보이더라도 해석력이 부족하면 어떤 문제가 발생할까?

-

데이터 불균형이 의료 AI의 편향된 진단 결과로 이어질 수 있는 이유는 무엇인가?

-

오진 발생 시, 책임은 AI 개발자, 의료진, 병원 중 누구에게 있는가?

-

Industry Case Studies

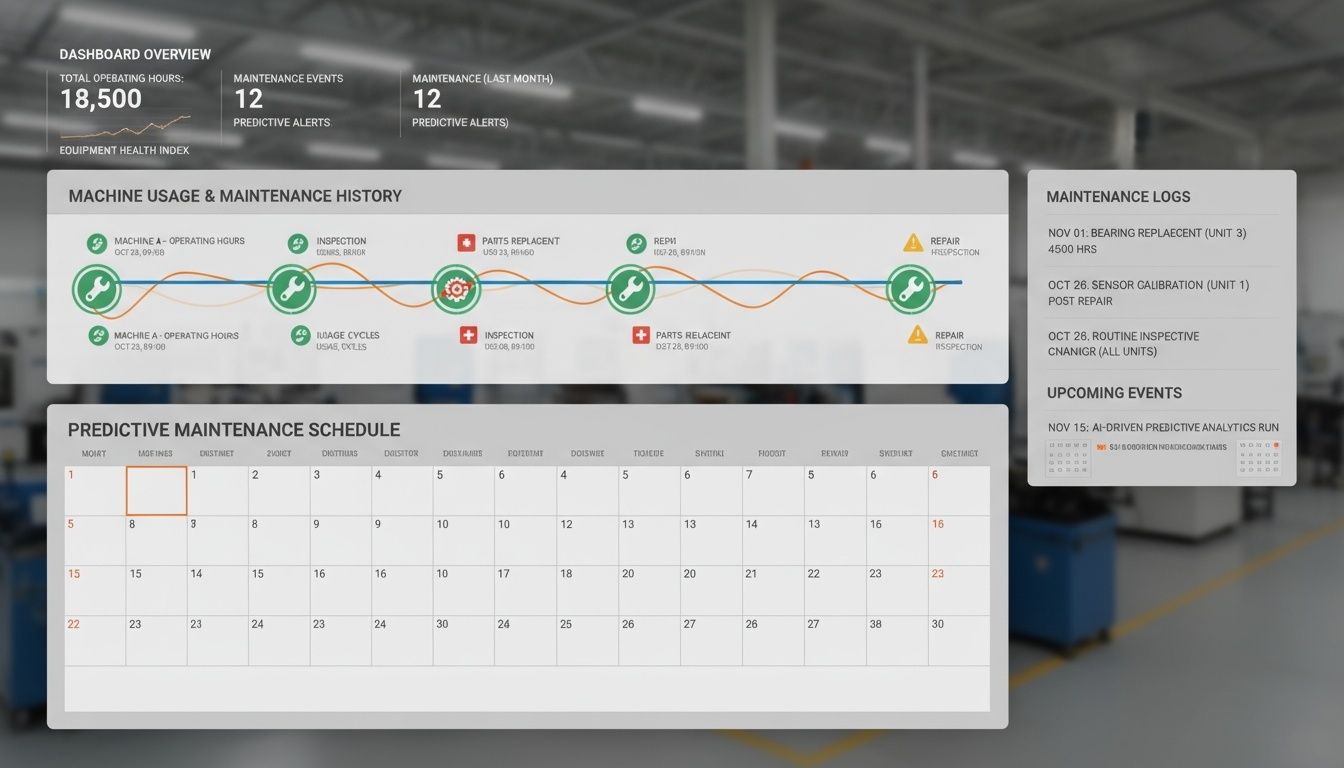

Predictive Maintenance

산업 현장에서 설비의 갑작스러운 고장은 생산 중단, 비용 증가, 납기 지연 등 큰 손실로 이어진다. Predictive Maintenance는 센서 데이터를 기반으로 설비의 고장 시점을 미리 예측하여 사전 점검과 유지보수 계획을 가능하게 함으로써 운영 안정성과 비용 절감을 동시에 달성하는 접근 방식이다.

문제 정의

설비의 고장 가능성을 조기에 감지하여 계획되지 않은 다운타임을 최소화하는 것이 목표이다. 고장을 미리 예측할 수 있다면 불필요한 정비를 줄이고, 필요한 시점에 최적의 유지보수 조치를 취할 수 있다.

데이터 예시

- 센서 시계열 데이터 (온도, 진동, 전류 등)

- 설비 사용 이력 및 유지보수 기록

분석 기법

-

시계열 예측 모델 ARIMA, LSTM과 같은 예측 모델을 활용해 센서 데이터의 변화를 분석하고 향후 상태를 예측함으로써 고장 발생 가능성을 사전에 파악한다.

-

이상 탐지 및 RUL 계산 정상 작동 패턴과의 차이를 기반으로 이상 상태를 탐지하며, Remaining Useful Life(RUL)를 산출하여 설비가 얼마나 더 사용할 수 있는지를 추정한다.

-

RUL: 현재 상태와 열화 추세를 토대로 잔여 수명을 추정해 교체·정비 시점을 최적화한다.

-

rul-datasets: CMAPSS·PHM08·Pronostia 등 대표 RUL 데이터셋을 바로 로드하고 전처리를 지원한다.

-

rul-models: LSTM·GRU·TCN·FCN 등 Torch 기반 RUL 베이스라인과 학습 루프를 제공한다.

-

-

기대 효과 및 분석 인사이트

Predictive Maintenance를 도입하면 갑작스러운 설비 고장을 예방하여 생산 중단을 최소화하고 유지보수 비용을 절감할 수 있다. 또한 고장 직전의 패턴을 시각화하여 관리자가 이상 징후를 직관적으로 이해할 수 있도록 지원한다.

실제 운영 환경에 적용할 경우 점검 최소화, 부품 교체 주기 최적화, 생산 효율 향상 등의 효과가 나타나며 이를 측정할 수 있는 대표적 지표로는 다운타임 감소율, 유지보수 비용 절감률, 고장 예측 정확도가 있다.

Mini Project (팀 수행)

-

2명 이상이 팀으로 진행할 것

-

토론 결과는 보고서로 작성하여 제출할 것 (제출 파일:

.hwp,.docx) -

토론 주제

-

(선택) Remaining Useful Life(RUL) 예측이 가능할 때 유지보수 정책은 어떻게 달라질 수 있는가?

-

시계열 기반 모델과 이상 탐지 기반 모델을 결합하는 이유는 무엇인가?

-

예측 정확도 외에 현장에서 중요한 성과 지표에는 무엇이 있을까?

-

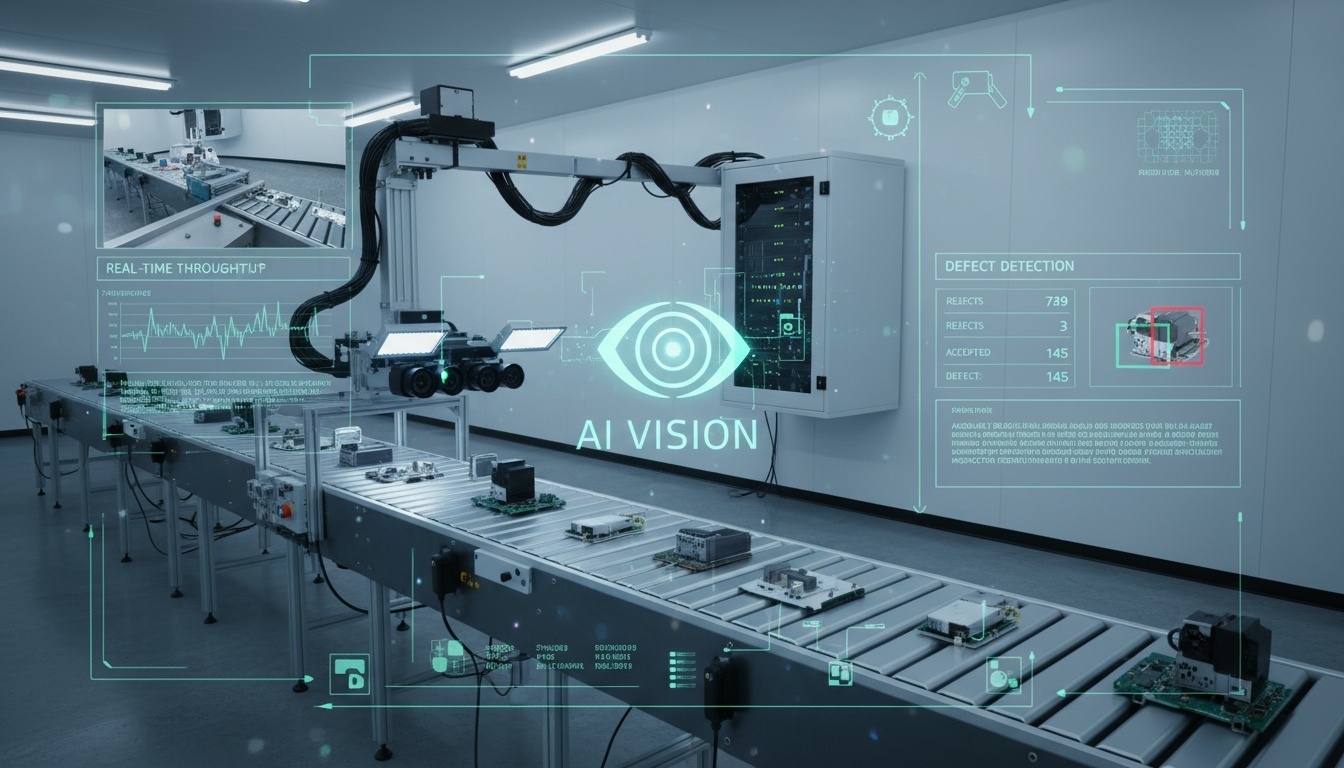

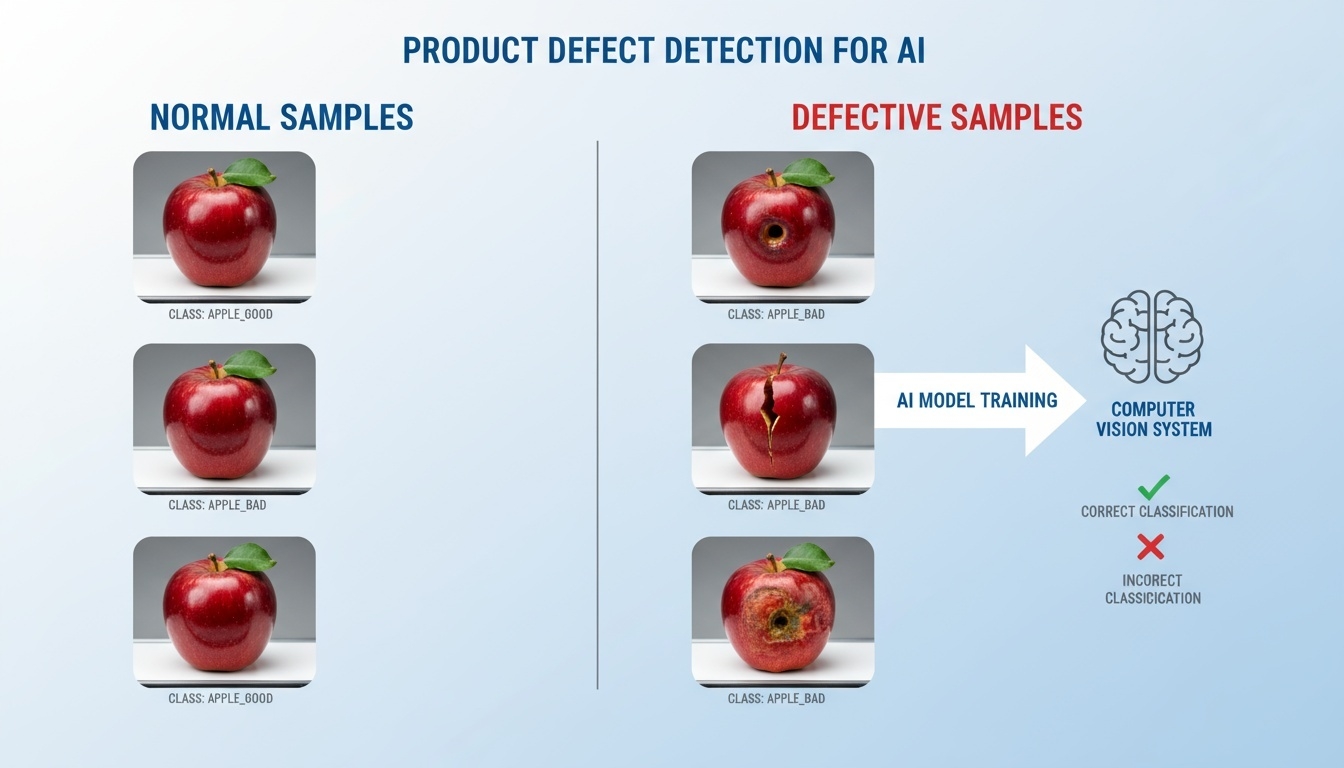

Vision-Based Quality Control

제조 공정에서는 제품 불량을 빠르게 식별하고 제거하는 것이 품질 관리의 핵심이다. Vision-Based Quality Control은 카메라와 딥러닝 기반 영상 분석 기술을 활용하여 생산 라인에서 불량품을 실시간으로 자동 검출하는 시스템을 의미한다. 이를 통해 검사 정확도를 높이고 사람의 수작업 검사 과정에서 발생하는 누락과 비용을 줄일 수 있다.

문제 정의

생산 공정 중 촬영된 이미지나 영상 데이터를 분석하여 정상 제품과 불량 제품을 자동으로 구분하는 것이 목표이다. 검사 속도, 정확성, 일관성이 중요하며 실시간 처리 능력이 요구된다.

데이터 예시

- 공정 중 촬영된 제품 이미지

- 생산 라인 영상 데이터

- 정상 및 불량 샘플 데이터셋

분석 기법

-

딥러닝 기반 영상 분류 CNN이나 Vision Transformer(ViT)를 활용하여 제품 이미지를 분석하고 정상 여부를 분류하는 모델을 구축한다.

-

이상 탐지 모델 AutoEncoder 기반의 비지도 학습 기법을 적용하여 정상 제품의 특징을 학습한 후 재구성 오류를 통해 불량 여부를 탐지한다.

기대 효과 및 분석 인사이트

Vision-Based Quality Control 시스템을 도입하면 검사 자동화를 통해 검사 정확도 향상과 인건비 절감 효과를 동시에 얻을 수 있다. 또한 일관된 품질 관리를 통해 불량률을 낮추고 고객 만족도를 높일 수 있다.

실제 도입 시 성과를 정량적으로 측정할 수 있는 대표적 지표는 다음과 같다. 불량 검출률 개선, 검사 비용 절감률, 자동화 도입에 따른 ROI(Return on Investment) 등이다.

Mini Project (팀 수행)

-

2명 이상이 팀으로 진행할 것

-

토론 결과는 보고서로 작성하여 제출할 것 (제출 파일:

.hwp,.docx) -

토론 주제

-

영상 기반 검사 자동화가 품질 관리 프로세스에 미치는 가장 큰 변화는 무엇인가?

-

(선택) CNN과 ViT 중 제조 현장에서 어떤 모델이 더 적합하다고 판단할 수 있는가?

-

데이터 기반 이상 탐지가 사람의 수작업 검사와 비교해 가지는 강점은 무엇인가?

-

Mini Capstone

13주차의 도전 과제는 데이터 시각화 스토리텔링을 실제로 구현하는 미니 캡스톤 프로젝트이다.

팀 또는 자신이 선택한 주제를 기반으로 하나의 대시보드를 설계하고, 데이터 인사이트를 시각적·서사적으로 전달하는 경험을 쌓는다.

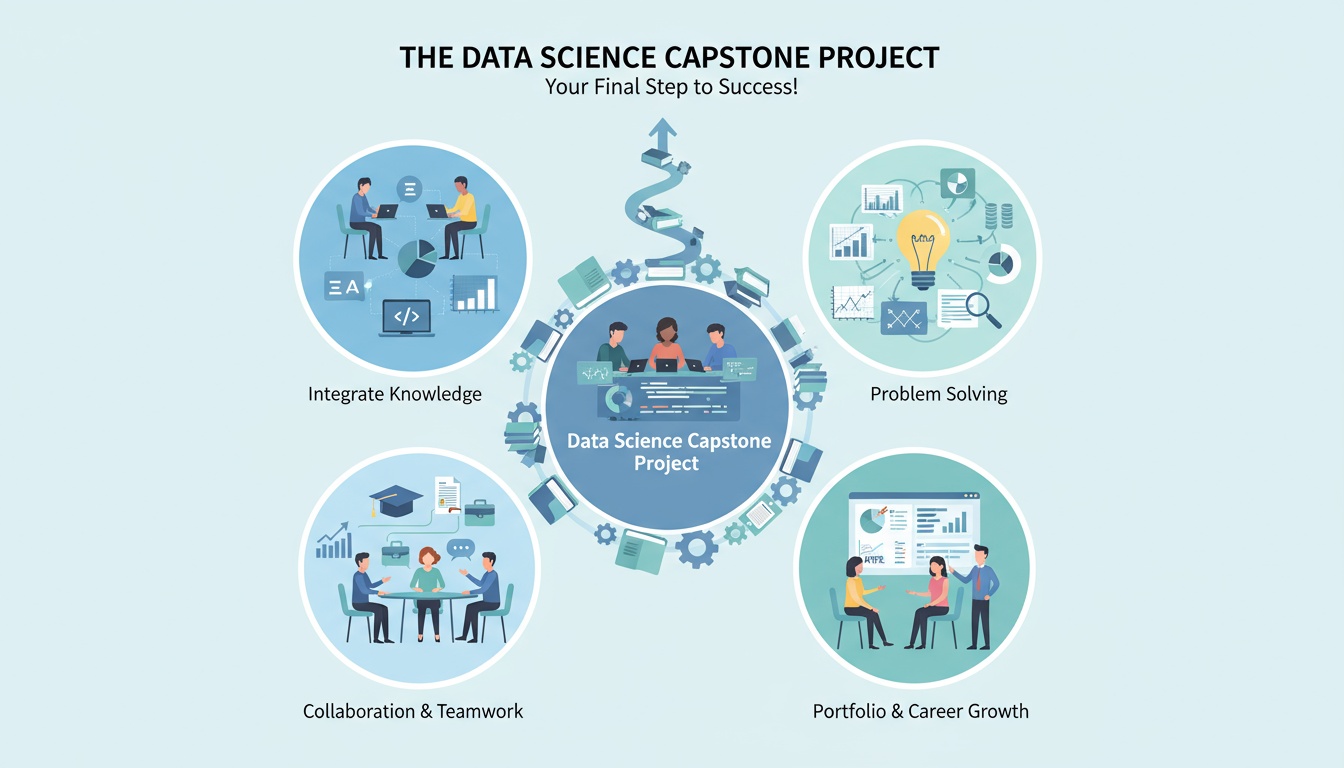

캡스톤(Capstone)이란 무엇인가?

‘캡스톤(Capstone)’은 본래 건축에서 건물의 맨 위를 완성하는 마감석을 뜻한다.

대학 교육에서는 이 개념을 차용해, 학생들이 그동안 배운 지식과 기술을 하나의 완성된 프로젝트 형태로 통합하는 학습 활동을 의미한다.

즉, 캡스톤 프로젝트는 학기나 전공 과정의 마지막 단계에서 수행하는 종합 실무형 과제이다.

단순한 과제 제출이 아니라, 실제 데이터를 다루고 문제를 정의하며 결과를 스스로 도출하는 창의적 문제 해결 경험을 중심으로 한다. 일부 대학에서는 졸업을 위한 필수 과목으로 최고 학년에서 종합설계 또는 졸업 프로젝트 등과 같은 과목으로 운영하기도 한다.

대학생이 캡스톤 프로젝트를 수행하는 이유

| 이유 | 설명 |

|---|---|

| 이론의 실제 적용 | 교과서에서 배운 분석 기법과 모델링 방법을 실제 데이터에 적용해본다. |

| 창의적 문제 해결 경험 | 스스로 주제를 선택하고 방법을 설계하며 문제를 해결하는 과정을 통해 논리적 사고력을 기른다. |

| 팀워크와 협업 능력 향상 | 여러 전공과 역할이 함께 어우러진 팀 단위 프로젝트를 통해 실무형 협업 능력을 배운다. |

| 포트폴리오 구축 | 프로젝트 결과물을 향후 취업, 대학원 진학, 연구 활동의 대표 사례로 활용할 수 있다. |

| 비판적 사고와 자기 주도성 강화 | 단순한 과제 수행이 아닌, 스스로 계획·분석·평가하는 자기 주도적 학습 과정이 된다. |

캡스톤 프로젝트의 성과 목표

캡스톤의 목표는 "완성된 결과물"뿐 아니라, "과정(Process)에서의 성장"이다.

| 목표 영역 | 구체적 성과 |

|---|---|

| 기술적 성취 | 데이터 수집·분석·모델링 능력 향상 |

| 논리적 사고력 | 문제를 정의하고, 가설을 세우며, 결과를 해석하는 과정의 체계화 |

| 창의성 | 기존 방법을 개선하거나 새로운 아이디어를 도입 |

| 협업 및 커뮤니케이션 | 역할 분담, 회의, 발표 등 협업 과정 경험 |

| 실무 감각 | 실제 현업 데이터 분석 흐름을 체험하고 보고서·대시보드 형태로 전달 |

데이터사이언스 과목에서 캡스톤을 해야 하는 이유

데이터사이언스는 단순히 코드를 배우는 학문이 아니라, 데이터를 통해 세상의 문제를 정의하고 해결하는 학문이다.

따라서 이론과 실습만으로는 한계가 있으며, 실제 프로젝트 수행을 통해서만 진정한 실력을 체득할 수 있다.

| 이유 | 내용 |

|---|---|

| 통합적 학습 | 데이터 전처리, 시각화, 모델링, 해석 등 과목 전체 내용을 하나로 연결 |

| 실제 문제 해결 경험 | 실제 사회·산업 데이터를 분석하며 현장감 있는 학습 경험 |

| 성과 기반 평가 | 단순 시험 점수가 아닌, 분석 과정과 결과의 완성도로 성과 평가 가능 |

| 윤리·공정성 학습의 전 단계 | 14주차의 ‘데이터 윤리와 편향’ 토론으로 이어지는 준비 과정 역할 수행 |

결국 데이터사이언스 캡스톤은 학생이 “데이터로 문제를 정의하고, 분석하고, 스토리로 전달할 수 있는가”를 직접 증명하는 학습의 마무리이자 출발점이다.

미니 캡스톤 안내

프로젝트 목표

-

데이터 기반 의사결정 과정을 스토리텔링 형태로 표현한다.

-

대시보드 설계를 통해 분석 결과를 직관적·설득력 있게 시각화한다.

-

실무형 도구(Plotly, Dash 등)를 활용한다.

프로젝트 수행 팁

-

주제 및 데이터 선정 과정에서는 팀원간 토론을 강화하고 가장 많은 시간을 투입 (

5:3:2원칙)-

50% → 데이터 전처리 및 분석,

-

30% → 시각화 및 UI 통합,

-

20% → 발표 준비 및 문서 정리.

-

-

초기 설계 문서화 (Mini Design Doc 작성)

아이디어가 떠올랐을 때 바로 코딩하지 말고,

① 문제 정의 → ② 데이터 구조 → ③ 핵심 기능 → ④ 역할 분담을

간단한 문서나 화이트보드로 시각화해두면 시행착오를 크게 줄일 수 있다.

-

UI/UX 단순화 전략

-

“기능은 적더라도 보기 좋고 매끄럽게”가 평가에서 훨씬 유리

-

너무 많은 기능보다 핵심 정보를 보여줄 수 있는 대표적 시각화에 집중

-

-

기존에 잘 구현된 소스코드 확보 후 팀별로 변형 (Customizing 수행)

-

생산성 향상을 위해 AI 코딩 도구를 적극 활용 (

Gemini, Codex, Copilot등)- 자동 생성 코드가 항상 최적은 아니며, 데이터 구조에 맞게 수정·주석을 추가

-

시각화 도구 (Dash, Potly 등) 공식 사이트에서 지원하는 갤러리/템플릿 등 적극 활용

-

필요시 프런트 구현 기술 (

html, css, javascript) 추가 학습 -

리드미(

README.md) 작성-

최종 대시보드나 시각화 결과를 이미지·GIF로 저장해 Github README나 개인 포트폴리오에 포함

-

향후 취업용 자료로도 바로 활용 가능

-

수행 단계

| 단계 | 설명 | 산출물 |

|---|---|---|

| 1. 주제 선정 및 팀 편성 | 관심 있는 산업 또는 사회 이슈를 선택하고, 3~4인으로 팀을 구성하여 역할을 분담한다. (예: 데이터 담당, 시각화 담당, 발표 담당 등) |

팀 구성표 및 프로젝트 제안서 (1쪽 요약본) |

| 2. 데이터 수집 및 전처리 | 공공데이터, Kaggle 등에서 데이터를 확보하고, 결측치·이상치·스케일 차이를 보정한다. 팀원 간 역할을 분담하여 데이터 품질을 확보한다. |

정제된 데이터셋 (.csv) |

| 3. 탐색적 분석 (EDA) | 주요 변수의 분포, 상관관계, 트렌드를 시각화하고 데이터에서 의미 있는 통찰을 도출한다. 협업을 통해 분석 노트북을 통합 관리한다. |

분석 노트북 (.ipynb)또는 파이썬 스크립트 ( .py) |

| 4. 시각화 스토리텔링 구성 | Context–Insight–Action 구조로 내러티브를 설계한다. 팀 내 피드백 회의를 통해 시각화 흐름과 스토리 전개를 개선한다. |

시각화 설계 초안 |

| 5. 대시보드 구현 | Python(Dash/Plotly) 또는 BI 도구(Tableau, Data Studio 등)를 사용하여 대시보드를 제작한다. 팀원이 각 파트를 개발하고 최종 통합·검수한다. |

대시보드 캡처 또는 링크 |

| 6. 발표 및 피드백 | 팀별 10분 발표 및 질의응답을 진행하고, 타 팀과 상호 피드백을 교환하여 개선점을 공유한다. |

발표자료 (.pptx 또는 .pdf) |

| 7. 결과물 문서화 | 팀별 캡스톤 결과물을 보고서 형태로 정리 | 결과보고서 (.hwp 또는 .docx) |

시각화 구성 예시

| 시각화 유형 | 목적 | 예시 |

|---|---|---|

| 시계열 그래프 | 시간에 따른 변화 강조 | 교통량 추세, 전력 소비 변화 |

| 막대/파이 차트 | 범주별 비교 | 지역별 판매량, 연령대별 이용률 |

| 히트맵 | 밀집 패턴 시각화 | 혼잡 구간, 센서 이상 영역 |

| 지도 시각화 | 공간적 분포 분석 | 미세먼지 농도, 인구 이동 경로 |

| 워드클라우드 | 텍스트 감성 요약 | 리뷰 주요 키워드, 트렌드 주제 |

제출물 구성

-

제출물 문서:

.hwp또는.docx -

주제 개요 (문제 정의, 분석 목표 등)

-

팀원 소개: 팀원 프로필 (전공, 학번, 이름, 프로젝트 담당분야)

-

데이터셋 설명 (선정 사유, 출처, 크기, 주요 변수)

-

분석 과정 (EDA, 모델링, 주요 인사이트를 찾는 과정, 도출된 인사이트 등)

-

시각화 대시보드 (설명 캡처 또는 링크)

-

결론 및 제언 (정책·비즈니스 인사이트)

-

별도 제출 문서: 소스코드 (

.py또는.ipynb) -

참고 자료